India, durante mucho tiempo experta en utilizar la tecnología para persuadir al público, se ha convertido en un punto clave a nivel global en cuanto a cómo se está utilizando, y abusando, la IA en el discurso político, y específicamente en el proceso democrático. Las empresas tecnológicas, que crearon las herramientas en primer lugar, están haciendo viajes al país para impulsar soluciones.

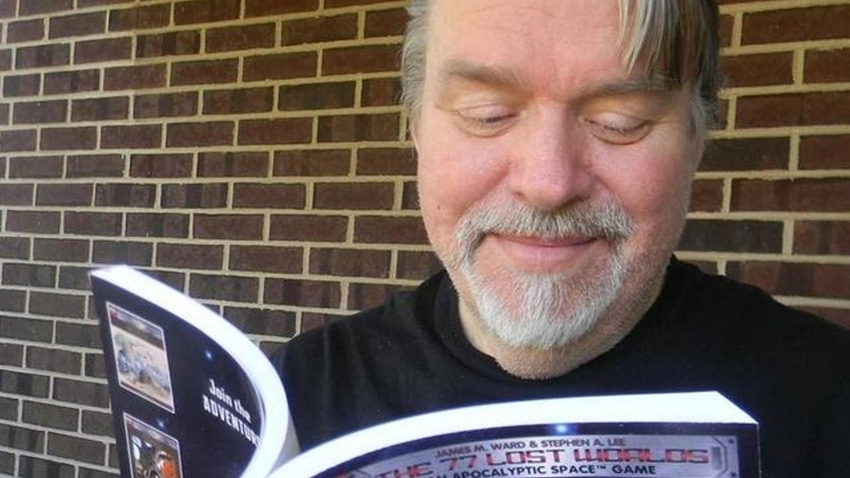

Este año, Andy Parsons, director senior de Adobe que supervisa su participación en la Iniciativa de Autenticidad de Contenido (CAI) de la industria, se sumergió en la vorágine cuando viajó a India para reunirse con medios y organizaciones tecnológicas en el país y promocionar herramientas que pueden integrarse en flujos de trabajo de contenido para identificar y señalar contenido de IA.

“En lugar de detectar lo falso o manipulado, nosotros como sociedad, y esto es una preocupación internacional, deberíamos empezar a declarar la autenticidad, es decir, decir si algo generado por IA debe ser conocido por los consumidores”, dijo en una entrevista.

Parsons agregó que algunas compañías indias —actualmente no forman parte de un acuerdo de seguridad electoral de IA en Munich firmado por OpenAI, Adobe, Google y Amazon en febrero— tenían la intención de construir una alianza similar en el país.

“La legislación es algo muy complicado. Suponer que el gobierno legislara correctamente y lo suficientemente rápido en cualquier jurisdicción es algo en lo que es difícil confiar. Es mejor que el gobierno tome un enfoque muy estable y se tome su tiempo”, dijo.

Las herramientas de detección son famosamente inconsistentes, pero son un comienzo para solucionar algunos de los problemas, o al menos así dice el argumento.

“El concepto ya está bien entendido”, dijo durante su visita a Delhi. “Estoy ayudando a crear conciencia de que las herramientas también están listas. No es solo una idea. Esto ya está implementado”.

La CAI —que promueve estándares abiertos y libres de regalías para identificar si el contenido digital fue generado por una máquina o por un humano— precede a la actual histeria en torno a la IA generativa: fue fundada en 2019 y ahora cuenta con 2,500 miembros, incluyendo Microsoft, Meta y Google, The New York Times, The Wall Street Journal y la BBC.

Al igual que hay una industria en crecimiento en torno al negocio de aprovechar la IA para crear medios, también se está creando una más pequeña para intentar corregir algunas de las aplicaciones más nefastas de eso.

Así que en febrero de 2021, Adobe dio un paso más allá al construir una de esas normas por sí misma y cofundó la Coalición para la Procedencia y Autenticidad del Contenido (C2PA) con ARM, BBC, Intel, Microsoft y Truepic. La coalición tiene como objetivo desarrollar un estándar abierto que aproveche los metadatos de imágenes, videos, textos y otros medios para resaltar su procedencia y contar a las personas sobre el origen del archivo, la ubicación y la hora de su generación, y si fue alterado antes de llegar al usuario. La CAI trabaja con C2PA para promover el estándar y hacerlo disponible para las masas.

Ahora está participando activamente con gobiernos como el de India para ampliar la adopción de ese estándar y destacar la procedencia del contenido de IA y colaborar con las autoridades en el desarrollo de pautas para el avance de la IA.

Adobe no tiene nada que perder, pero también todo, al desempeñar un papel activo en este juego. Todavía no está adquiriendo ni construyendo grandes modelos de lenguaje (LLMs) propios, pero como hogar de aplicaciones como Photoshop y Lightroom, es el líder del mercado en herramientas para la comunidad creativa, por lo que no solo está creando nuevos productos como Firefly para generar contenido de IA de forma nativa, sino que también está infundiendo productos heredados con IA. Si el mercado se desarrolla como algunos creen que lo hará, la IA será imprescindible en la mezcla si Adobe quiere mantenerse en la cima. Si los reguladores (o el sentido común) tienen su camino, el futuro de Adobe bien podría depender de lo exitoso que sea en asegurarse de que lo que vende no contribuya al desastre.

La imagen más grande en India, en cualquier caso, es realmente un desastre.

Google se enfocó en India como un campo de pruebas para cómo vetará el uso de su herramienta de IA generativa Gemini cuando se trata de contenido electoral; los partidos están utilizando la IA para crear memes con semejanzas de oponentes; Meta ha establecido una “línea directa” de deepfake para WhatsApp, tal es la popularidad de la plataforma de mensajería en la difusión de mensajes AI impulsados; y en un momento en el que los países están cada vez más alarmados por la seguridad de la IA y lo que deben hacer para asegurarse de ello, veremos cuál será el impacto de la decisión del gobierno de India en marzo de flexibilizar las normas sobre cómo se construyen, prueban y despliegan nuevos modelos de IA. Ciertamente se pretende fomentar más actividad de IA, en cualquier caso.

Usando su estándar abierto, la C2PA ha desarrollado una etiqueta de nutrición digital para el contenido llamada Credenciales de Contenido. Los miembros de la CAI están trabajando para implementar la marca de agua digital en su contenido para informar a los usuarios sobre su procedencia y si fue generado por IA. Adobe tiene Credenciales de Contenido en todas sus herramientas creativas, incluyendo Photoshop y Lightroom. También se adjunta automáticamente al contenido de IA generado por el modelo de IA de Adobe, Firefly. El año pasado, Leica lanzó su cámara con Credenciales de Contenido incorporadas, y Microsoft agregó Credenciales de Contenido a todas las imágenes generadas por IA utilizando Bing Image Creator.

Parsons le dijo a TechCrunch que la CAI está hablando con gobiernos globales en dos áreas: una es ayudar a promover el estándar como un estándar internacional, y la otra es adoptarlo.

“En un año electoral, es especialmente crítico para los candidatos, partidos, oficinas y administraciones en funciones que lanzan material a los medios y al público todo el tiempo asegurarse de que se sepa que si algo se publica desde la oficina del PM [Narendra] Modi, en realidad proviene de la oficina del PM Modi. Ha habido muchos incidentes donde eso no es así. Por lo tanto, es muy importante comprender que algo sea verdaderamente auténtico para los consumidores, verificadores de hechos, plataformas e intermediarios”, dijo.

La gran población de India, su vasta diversidad lingüística y demográfica hacen que sea un desafío controlar la desinformación, agregó, a favor de etiquetas simples para cortar a través de eso.

“Eso es un poco ‘CR’… son dos letras occidentales como la mayoría de las herramientas de Adobe, pero esto indica que hay más contexto por mostrar”, dijo.

La controversia continúa en torno a cuál podría ser el verdadero punto detrás de que las empresas tecnológicas apoyen algún tipo de medida de seguridad de IA: ¿Se trata realmente de una preocupación existencial, o simplemente de tener un asiento en la mesa para dar la impresión de una preocupación existencial, al mismo tiempo que se aseguran de que se protejan sus intereses en el proceso de elaboración de reglas?

“No es generalmente controvertido con las empresas involucradas, y todas las empresas que firmaron el reciente acuerdo de Munich, incluyendo Adobe, que se reunieron, dejaron de lado las presiones competitivas porque estas ideas son algo que todos necesitamos hacer”, dijo en defensa del trabajo.